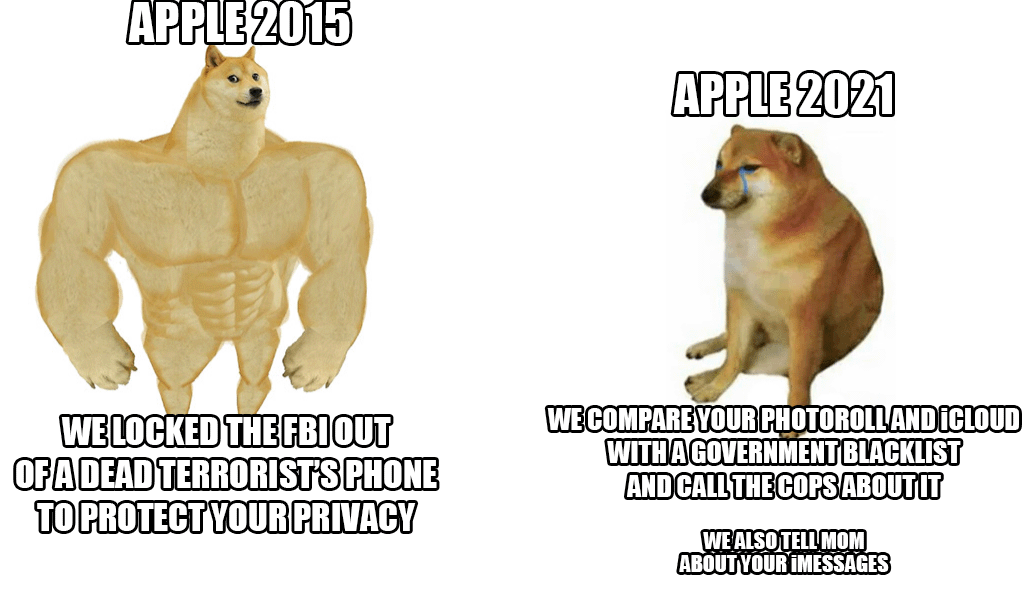

Eind vorige week onthulde Apple een nieuw anti-kindermisbruiksysteem dat vrijwel ieders iCloud-foto's scant. Hoewel het idee op het eerste gezicht goed klinkt, aangezien kinderen echt tegen deze actie moeten worden beschermd, werd de Cupertino-gigant toch bekritiseerd door een lawine - niet alleen van gebruikers en beveiligingsexperts, maar ook van de gelederen van de werknemers zelf.

Volgens de laatste informatie van een gerespecteerd bureau Reuters een aantal medewerkers uitten hun zorgen over dit systeem in een interne communicatie op Slack. Naar verluidt zouden ze bang moeten zijn voor mogelijk misbruik door autoriteiten en overheden, die deze mogelijkheden zouden kunnen misbruiken om bijvoorbeeld mensen of geselecteerde groepen te censureren. De onthulling van het systeem leidde tot een heftig debat, dat al meer dan 800 individuele berichten bevat binnen de eerder genoemde Slack. Kortom: medewerkers maken zich zorgen. Zelfs veiligheidsexperts hebben eerder de aandacht gevestigd op het feit dat het in de verkeerde handen een werkelijk gevaarlijk wapen zou zijn dat wordt gebruikt om activisten, de door hen genoemde censuur en dergelijke te onderdrukken.

Het goede nieuws (tot nu toe) is dat de nieuwigheid pas in de Verenigde Staten zal beginnen. Op dit moment is het niet eens duidelijk of het systeem ook binnen de lidstaten van de Europese Unie zal worden gebruikt. Ondanks alle kritiek blijft Apple echter op zichzelf staan en verdedigt het systeem. Hij stelt vooral dat alle controle binnen het toestel plaatsvindt en als er eenmaal een match is, wordt de zaak pas op dat moment opnieuw gecontroleerd door een Apple-medewerker. Alleen naar eigen goeddunken zal het worden overgedragen aan de relevante autoriteiten.

Het zou kunnen interesseer je

Ik zou niet graag willen overstappen van iCloud naar iets dat veilig en echt privé is, maar als Apple erop aandringt, stop ik toch met betalen.

Het zal (voorlopig) alleen actief zijn in de VS

Het maakt eigenlijk niet uit waar het juridisch van toepassing zal zijn. Die technologie zal al beschikbaar zijn en ingezet worden. Dat is het grootste risico.