De afgelopen jaren heeft de wereld van mobiele telefoons enorme veranderingen ondergaan. We kunnen in vrijwel alle aspecten fundamentele verschillen zien, ongeacht of we ons concentreren op grootte of ontwerp, prestaties of andere slimme functies. De kwaliteit van camera’s speelt momenteel een relatief belangrijke rol. Op dit moment zouden we kunnen zeggen dat dit een van de belangrijkste aspecten van smartphones is, waarin de vlaggenschepen voortdurend concurreren. Wanneer we bijvoorbeeld Android-telefoons vergelijken met de iPhone van Apple, vinden we bovendien een aantal interessante verschillen.

Het zou kunnen interesseer je

Als je geïnteresseerd bent in de wereld van mobiele technologie, dan weet je zeker dat een van de grootste verschillen te vinden is in het geval van sensorresolutie. Terwijl Androids vaak een lens bieden met meer dan 50 Mpx, gokt de iPhone al jaren op slechts 12 Mpx en kan hij nog steeds foto's van betere kwaliteit bieden. Er wordt echter niet veel aandacht besteed aan beeldfocussystemen, waar we een nogal interessant verschil tegenkomen. Concurrerende telefoons met het Android-besturingssysteem vertrouwen vaak (gedeeltelijk) op de zogenaamde laser-autofocus, terwijl smartphones met het gebeten appellogo niet over deze technologie beschikken. Hoe werkt het eigenlijk, waarom wordt het gebruikt en op welke technologieën vertrouwt Apple?

Laserfocus versus iPhone

De genoemde laserfocustechnologie werkt vrij eenvoudig en het gebruik ervan is heel logisch. In dit geval is in de fotomodule een diode verborgen, die straling uitzendt wanneer de trekker wordt ingedrukt. In dit geval wordt een straal uitgezonden die terugkaatst op het gefotografeerde onderwerp/object en terugkeert. Deze tijd kan worden gebruikt om snel de afstand te berekenen via software-algoritmen. Helaas heeft het ook zijn donkere kant. Bij het maken van foto's op grotere afstanden is de laserfocus niet meer zo nauwkeurig, of bij het maken van foto's van transparante objecten en ongunstige obstakels die de straal niet betrouwbaar kunnen reflecteren. Om deze reden vertrouwen de meeste telefoons nog steeds op het beproefde algoritme om scènecontrast te detecteren. Een sensor hiermee kan het perfecte beeld vinden. De combinatie werkt zeer goed en zorgt voor een snelle en nauwkeurige beeldscherpstelling. De populaire Google Pixel 6 beschikt bijvoorbeeld over dit systeem (LDAF).

Aan de andere kant hebben we de iPhone, die een beetje anders werkt. Maar in de kern is het vrijwel hetzelfde. Wanneer u de trekker indrukt, speelt de ISP- of Image Signal Processor-component, die de afgelopen jaren aanzienlijk is verbeterd, een sleutelrol. Deze chip kan de contrastmethode en geavanceerde algoritmen gebruiken om onmiddellijk de beste focus te evalueren en een foto van hoge kwaliteit te maken. Op basis van de verkregen gegevens is het uiteraard noodzakelijk om de lens mechanisch naar de gewenste positie te verplaatsen, maar alle camera's in mobiele telefoons werken op dezelfde manier. Hoewel ze worden bestuurd door een "motor", is hun beweging niet roterend, maar lineair.

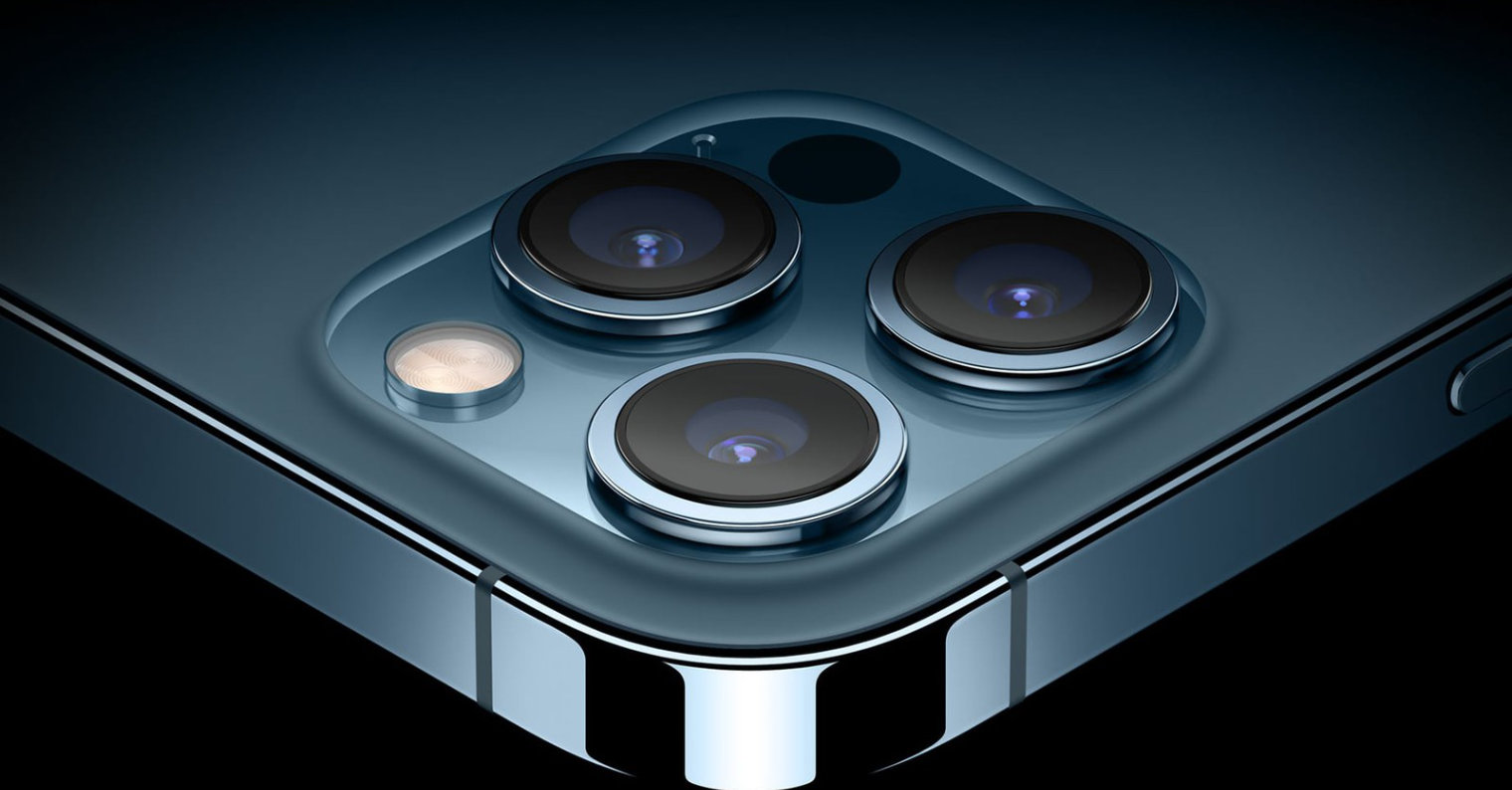

Een stap verder zijn de iPhone 12 Pro (Max) en iPhone 13 Pro (Max) modellen. Zoals je misschien al geraden hebt, zijn deze modellen uitgerust met een zogenaamde LiDAR-scanner, die direct de afstand tot het gefotografeerde onderwerp kan bepalen en deze kennis in zijn voordeel kan gebruiken. In feite ligt deze technologie dicht bij de genoemde laserfocus. LiDAR kan met laserstralen een 3D-model van de omgeving maken en wordt daarom vooral gebruikt voor het scannen van kamers, in autonome voertuigen en voor het maken van foto's, voornamelijk portretten.

Het zou kunnen interesseer je

Adam Kos

Adam Kos

Vlieg de wereld rond met Apple

Vlieg de wereld rond met Apple